[ad_1]

Cada aplicativo gera dados, mas o que esses dados significam? Esta é uma pergunta que todos os cientistas de dados são contratados para responder.

Não há dúvida de que essas informações são a mercadoria mais preciosa para uma empresa. Mas dar sentido aos dados, criar insights e transformá-los em decisões é ainda mais importante.

À medida que o volume dos dados continua crescendo, os pipelines de análise de dados precisam ser escalonáveis para se adaptar à taxa de mudança. E, por esse motivo, escolher configurar o pipeline na nuvem faz todo o sentido (já que a nuvem oferece escalabilidade e flexibilidade sob demanda).

Neste artigo, vou desmistificar como construir um pipeline de processamento de dados escalonável e adaptável no Google Cloud. E não se preocupe – esses conceitos são aplicáveis em qualquer outra nuvem ou pipeline de dados no local.

5 etapas para criar um pipeline de análise de dados:

- Primeiro você ingere os dados da fonte de dados

- Em seguida, processe e enriqueça os dados para que seu sistema downstream possa utilizá-los no formato que entender melhor.

- Em seguida, você armazena os dados em um data lake ou data warehouse para arquivamento de longo prazo ou para relatórios e análises.

- Você pode então analisar os dados alimentando-os em ferramentas analíticas.

- Aplique o aprendizado de máquina para previsões ou crie relatórios para compartilhar com suas equipes.

Vamos examinar cada uma dessas etapas com mais detalhes.

Como capturar os dados

Dependendo de onde seus dados estão vindo, você pode ter várias opções para ingeri-los.

- Use ferramentas de migração de dados para migrar dados do local ou de uma nuvem para outra. O Google Cloud oferece um serviço de transferência de armazenamento para este propósito.

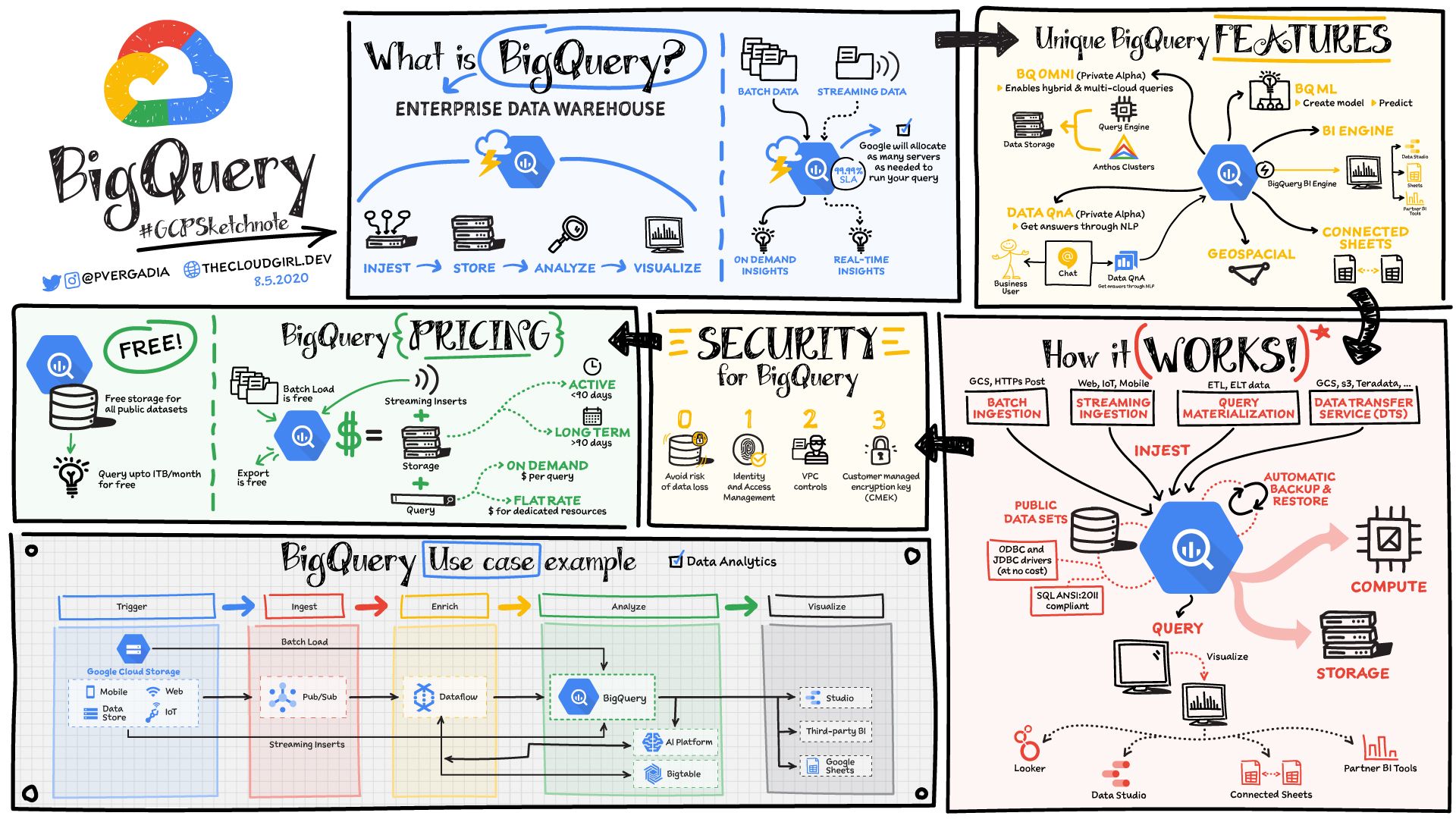

- Para ingerir dados de seus serviços saas de terceiros, use APIs e envie os dados para o data warehouse. No Google Cloud BigQuery, o data warehouse sem servidor fornece um serviço de transferência de dados que permite que você traga dados de aplicativos saas como YouTube, Google Ads, Amazon S3, Teradata, ResShift e muito mais.

- Você também pode transmitir dados em tempo real de seus aplicativos com o serviço Pub / Sub. Você configura uma fonte de dados para enviar mensagens de eventos para o Pub / Sub, de onde um assinante pega a mensagem e executa a ação apropriada sobre ela.

- Se você tiver dispositivos IoT, eles podem transmitir dados em tempo real usando o Cloud IoT core, que oferece suporte ao protocolo MQTT para os dispositivos IoT. Você também pode enviar dados de IoT ao Pub / Sub.

Como processar os dados

Uma vez que os dados são ingeridos, eles precisam ser processados ou enriquecidos para torná-los úteis para os sistemas downstream.

Existem três ferramentas principais que ajudam você a fazer isso no Google Cloud:

- Dataproc é essencialmente Hadoop gerenciado. Se você usa o ecossistema Hadoop, sabe que pode ser complicado configurá-lo, envolvendo horas e até dias. O Dataproc pode girar um cluster em 90 segundos para que você possa começar a analisar os dados rapidamente.

- Dataprep é uma ferramenta de interface gráfica de usuário inteligente que ajuda os analistas de dados a processar os dados rapidamente, sem a necessidade de escrever nenhum código.

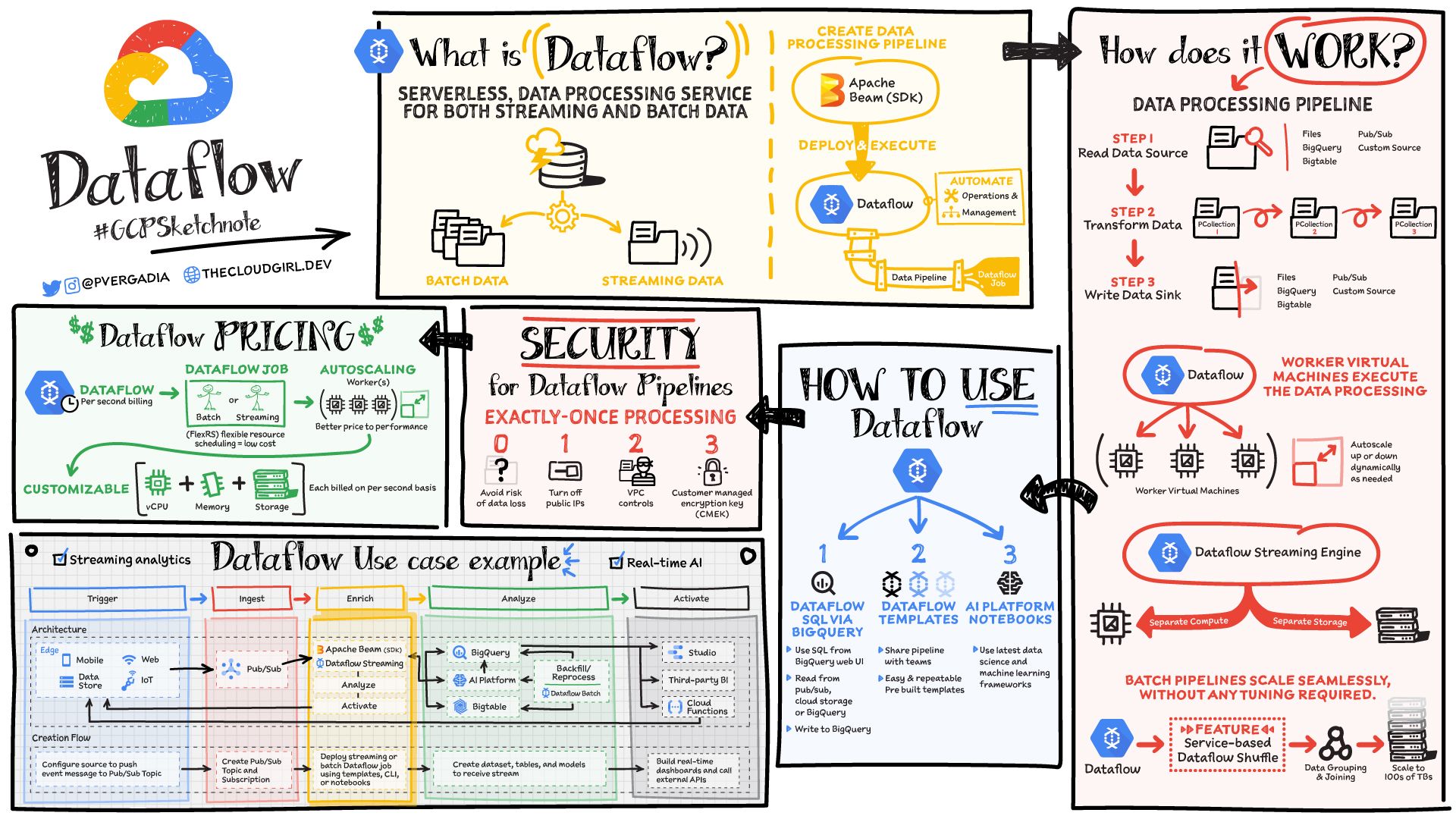

- Dataflow é um serviço de processamento de dados sem servidor para streaming e dados em lote. Ele é baseado no SDK de código aberto do Apache Beam, tornando seus pipelines portáteis. O serviço separa o armazenamento da computação, o que permite um escalonamento perfeito. Para obter mais detalhes, consulte o GCPSketchnote abaixo.

Como armazenar os dados

Depois de processados, você deve armazenar os dados em um data lake ou data warehouse para arquivamento de longo prazo ou para relatórios e análises.

Existem duas ferramentas principais que ajudam você a fazer isso no Google Cloud:

Google Cloud Storage é um armazenamento de objetos para imagens, vídeos, arquivos e assim por diante, que vem em 4 tipos:

- Armazenamento Padrão: Bom para dados “quentes” que são acessados com frequência, incluindo sites, streaming de vídeos e aplicativos móveis.

- Nearline Storage: Baixo custo. Bom para dados que podem ser armazenados por pelo menos 30 dias, incluindo backup de dados e conteúdo multimídia de cauda longa.

- Coldline Storage: Custo muito baixo. Bom para dados que podem ser armazenados por pelo menos 90 dias, incluindo recuperação de desastres.

- Armazenamento de arquivo: Preço mais baixo. Bom para dados que podem ser armazenados por pelo menos 365 dias, incluindo arquivos regulatórios.

BigQuery é um data warehouse sem servidor que se adapta perfeitamente a petabytes de dados sem ter que gerenciar ou manter nenhum servidor.

Você pode armazenar e consultar dados no BigQuery usando SQL. Assim, você pode compartilhar facilmente os dados e consultas com outras pessoas de sua equipe.

Ele também abriga centenas de conjuntos de dados públicos gratuitos que você pode usar em sua análise. E fornece conectores integrados a outros serviços para que os dados possam ser facilmente inseridos e extraídos para visualização ou processamento / análise posterior.

Como analisar os dados

Depois que os dados são processados e armazenados em um data lake ou data warehouse, eles estão prontos para serem analisados.

Se você estiver usando o BigQuery para armazenar os dados, poderá analisá-los diretamente no BigQuery usando SQL.

Se você estiver usando o Google Cloud Storage, poderá mover facilmente os dados para o BigQuery.

O BigQuery também oferece recursos de aprendizado de máquina com BigQueryML. Portanto, você pode criar modelos e prever diretamente na IU do BigQuery usando o SQL, talvez mais familiar.

Como usar e visualizar os dados

Usando os dados

Depois que os dados estão no data warehouse, você pode usá-los para obter insights e fazer previsões usando o aprendizado de máquina.

Para mais processamento e previsões, você pode usar a estrutura do Tensorflow e o AI Platform, dependendo de suas necessidades.

Tensorflow é uma plataforma de aprendizado de máquina de código aberto de ponta a ponta com ferramentas, bibliotecas e recursos da comunidade.

AI Platform torna mais fácil para desenvolvedores, cientistas de dados e engenheiros de dados otimizar seus fluxos de trabalho de ML. Inclui ferramentas para cada estágio do ciclo de vida do ML, começando em Preparação -> Compilar -> Validação -> Implantação.

Visualizando os dados

Existem muitas ferramentas diferentes para visualização de dados, e a maioria delas tem um conector para o BigQuery para criar gráficos facilmente na ferramenta de sua escolha.

O Google Cloud oferece algumas ferramentas que você pode considerar úteis.

- Data Studio é gratuito e se conecta não apenas ao BigQuery, mas também a muitos outros serviços para facilitar a visualização de dados. Se você já usou o Google Drive, compartilhar gráficos e painéis é exatamente assim – extremamente fácil.

- Além disso Looker é uma plataforma corporativa para business intelligence, aplicativos de dados e análises integradas.

Conclusão

Muitas coisas acontecem em um pipeline de análise de dados. Quaisquer que sejam as ferramentas que você escolher para usar, certifique-se de que elas possam ser dimensionadas conforme seus dados crescerem no futuro.

Para mais conteúdo desse tipo, você pode me seguir no Twitter, @pvergadia e visite meu site, thecloudgirl.dev.

[ad_2]

Fonte