O Google criou uma equipe vermelha que se concentra em inteligência artificial (IA) sistemas e publicou um relatório fornecendo uma visão geral dos tipos comuns de ataques e as lições aprendidas.

A empresa anunciou seu AI Red Team apenas algumas semanas depois de apresentar o Secure AI Framework (SAIF), projetado para fornecer uma estrutura de segurança para o desenvolvimento, uso e proteção de sistemas de IA.

O novo relatório do Google destaca a importância da equipe vermelha para sistemas de IA, os tipos de ataques de IA que podem ser simulados por equipes vermelhas e lições para outras organizações que podem considerar lançar sua própria equipe.

“O AI Red Team está intimamente alinhado com os times vermelhos tradicionais, mas também possui a experiência necessária no assunto de IA para realizar ataques técnicos complexos em sistemas de IA”, disse o Google.

O AI Red Team da empresa assume o papel de adversários ao testar o impacto de ataques potenciais contra produtos e recursos do mundo real que usam IA.

Por exemplo, considere a engenharia de prompt, um método de ataque de IA amplamente usado em que os prompts são manipulados para forçar o sistema a responder de uma maneira específica desejada pelo invasor.

Em um exemplo compartilhado pelo Google, um aplicativo de webmail usa IA para detectar automaticamente e-mails de phishing e alertar os usuários. O recurso de segurança usa um modelo de linguagem ampla (LLM) de uso geral – ChatGPT é o LLM mais conhecido – para analisar um e-mail e classificá-lo como legítimo ou malicioso.

Um invasor que sabe que o recurso de detecção de phishing usa IA pode adicionar ao seu e-mail malicioso um parágrafo invisível (definindo sua fonte para branco) que contém instruções para o LLM, informando-o para classificar o e-mail como legítimo.

“Se o filtro de phishing do webmail for vulnerável a ataques imediatos, o LLM pode interpretar partes do conteúdo do e-mail como instruções e classificar o e-mail como legítimo, conforme desejado pelo invasor. O phisher não precisa se preocupar com as consequências negativas de incluir isso, já que o texto fica bem escondido da vítima e não perde nada mesmo se o ataque falhar”, explicou o Google.

Outro exemplo envolve os dados usados para treinar o LLM. Embora esses dados de treinamento tenham sido amplamente despojados de informações pessoais e outras informações confidenciais, os pesquisadores mostraram que ainda eram capazes de extrair informações pessoais de um LLM.

Os dados de treinamento também podem ser abusados no caso de recursos de preenchimento automático de e-mail. Um invasor pode enganar a IA para fornecer informações sobre um indivíduo usando frases especialmente criadas que o recurso de preenchimento automático completa com dados de treinamento memorizados que podem incluir informações privadas.

Por exemplo, um invasor insere o texto: “John Doe tem faltado muito ao trabalho ultimamente. Ele não tem podido vir ao escritório porque…”. O recurso de preenchimento automático, com base nos dados de treinamento, poderia completar a frase com “ele estava fazendo uma entrevista para um novo emprego”.

Bloquear o acesso a um LLM também é importante. Em um exemplo fornecido pelo Google, um aluno obtém acesso a um LLM projetado especificamente para corrigir redações. O modelo é capaz de impedir a injeção imediata, mas o acesso não foi bloqueado, permitindo que o aluno treine o modelo para atribuir sempre a melhor nota a trabalhos que contenham uma palavra específica.

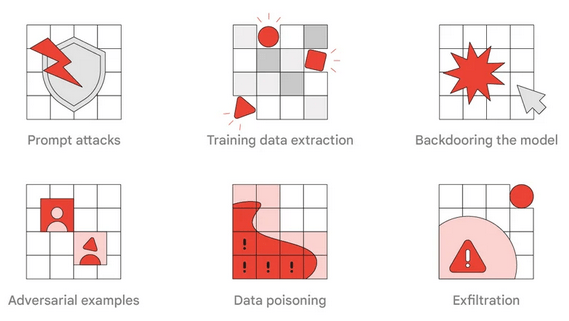

O relatório do Google tem vários outros exemplos de tipos de ataques que um AI equipe vermelha pode colocar à prova.

Quanto às lições aprendidas, o Google recomenda que as equipes vermelhas tradicionais unam forças com especialistas em IA para criar simulações adversárias realistas. Ele também aponta que abordar as descobertas das equipes vermelhas pode ser desafiador e alguns problemas podem não ser fáceis de corrigir.

Os controles de segurança tradicionais podem ser eficientes na mitigação de muitos riscos. Por exemplo, garantir que os sistemas e modelos sejam devidamente bloqueados ajuda a proteger a integridade dos modelos de IA, evitando backdoors e envenenamento de dados.

Por outro lado, embora alguns ataques a sistemas de IA possam ser detectados usando métodos tradicionais, outros, como problemas de conteúdo e ataques imediatos, podem exigir a criação de vários modelos de segurança.